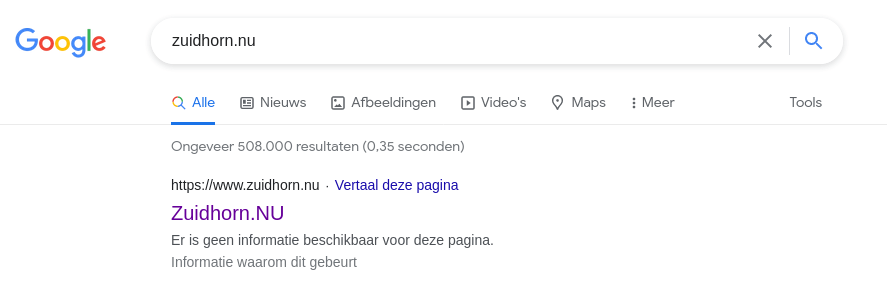

Als het verkeer naar je website zonder aanwijsbare reden opeens wegzakt is het handig te zoeken in Google naar de url van je website. Google en robots.txt is iets wat je kennelijk goed in de gaten moet houden.

Het overkwam mij bij een nieuwswebsite die ik beheer. Het bezoek via Google leek vrij plotseling totaal weg te blijven zonder aanwijsbare reden. De robots.txt bleek de oorzaak.

Tot mijn grote verbazing zag ik de melding op Google dat de robots.txt van de website google zou blokkeren. Wat niet het geval was. Er werden een aantal andere agressieve bots geblokkeerd volgens regels die al jaren zo werken. Kennelijk struikelt Google er sinds kort over.

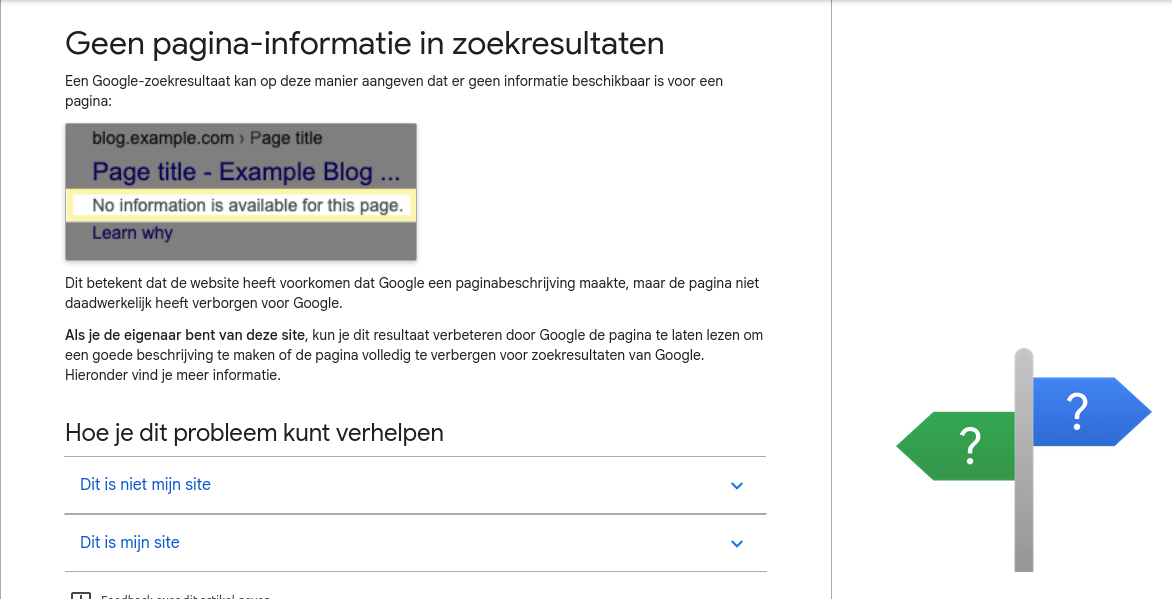

Als je doorklikt op “Informatie waarom dit gebeurt” krijg je te zien:

De oplossing die Google biedt (de robots.txt-tester in de search console) lijkt, althans op dit moment, niet te werken. Als je een domeinnaam uit de pull-down kiest gebeurt er helemaal niets.

Tijd om de robots.txt te inspecteren en (handmatig) aan te passen. Voor deze website bijvoorbeeld is de robots.txt als volgt en deze werkt correct.

User-agent: * Allow: /wp/wp-admin/admin-ajax.php Disallow: /wp/wp-admin/ Disallow: /wp/wp-content/uploads/wpo-plugins-tables-list.json Sitemap: https://gratiswordpressboek.nl/sitemap.xml Sitemap: https://gratiswordpressboek.nl/sitemap.rss

Google en robots.txt

Het vervelende is dat de verkeerde robots.txt bij de website in kwestie, zuidhorn.nu, was aangemaakt op basis van informatie zoals die nog overal is te vinden en volgens het format dat Google zelf geeft. Daarnaast is de site een geverifieerde Google site.

Google echter waarschuwt je nergens voor. Zij kunnen zonder dat je het weet de spelregels aanpassen want het is hún spelletje. Je zorgvuldig opgebouwde indexatie van je website, en de bijbehorende ranking, is zonder dat je het weet regelricht de bittenbak in. Door slechts een kleine wijziging, kennelijk, in hoe Google de robots.txt interpreteert.

Hoe los je dit op?

Fix je robots.txt en ga vervolgens naar de Google Search Console > URL Inspectie > Opnieuw aanvragen.

Je website wordt daarna opnieuw geïndexeerd door Google. Dit kan een tijd(je) duren.

Check regelmatig even in Google of je eigen site nog goed te vinden is… en nog een tip: houd de robots.txt zo simpel mogelijk.